| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

- TRUNCATE

- join

- PostgreSQL

- matplotlib

- having

- SQL

- airflow.cfg

- 머신러닝

- hackerrank

- 전처리

- 데이터리안 웨비나

- 프로그래머스

- not in

- SUM

- 데이터시각화

- MySQL

- 데이터분석

- 그로스해킹

- 결측값

- Limit

- SQLite

- 파이썬

- 다중 JOIN

- Round

- GROUPBY

- pandas

- solvesql

- airflow 설치

- seaborn

- Oracle

- Today

- Total

목록DevOps/GCP (5)

Milky's note

[GCP] Google Cloud SDK로 SSH 터널링 (로컬 cmd에서 서버 접속)

[GCP] Google Cloud SDK로 SSH 터널링 (로컬 cmd에서 서버 접속)

내가 현재 진행하고 있는 프로젝트는 GCP 기반으로 폐쇄망을 사용한다.추가로 Public IP도 사용하지 않고 GCP 내부 IP만 사용한다. 초반에 Airflow를 Public IP로 구성을 해놓았는데 내부 IP만 허용이 되는 정책으로 변경이 되었다...어쩔 수 없이 Airflow 서버를 내부 IP만 사용되게 하였는데 당연하게도 Airflow UI 접속이 불가능해졌다 ! 그래서 내가 생각한 방법은 로컬에서 서버로 접속하기 ! 내부 IP만 사용하지만 SSH 터널링을 사용하면 서버로 접속이 가능하다 ! 1. 로컬에 SSH 연결 외부 IP 없이 Airflow UI에 접속하기 위해 SSH 터널링을 사용할 수 있다.이 방법은 로컬에서 GCP의 VM 인스턴스에 SSH로 연결한 후,Airflow UI에 접근할 수 ..

[GCP] 랜딩존 설정으로 차단된 Google API 호출 (GA, GSC, Google Ads, Youtube)

[GCP] 랜딩존 설정으로 차단된 Google API 호출 (GA, GSC, Google Ads, Youtube)

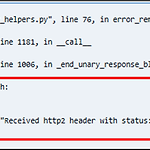

GCP 프로젝트가 랜딩존으로 들어가면서 네트워크 구성이 바뀌었다. 기존 내가 생성한 VPC에서 조직 범위에서 생성한 VPC가 공유되었고,공유된 VPC를 써서 Google 소유의 API들 호출이 오류가 발생했다.GA, GSC, Google Ads, Youtube 등... 발생한 오류는 다음과 같았다.google.api_core.exceptions.permissiondenied: 403 received http2 header with status: 403 랜딩존 설정으로 인하여 API 주소를 찾지 못하고 있다.해결 방법으로는 hosts 파일에 API를 직접 하나씩 등록해주어야 한다. sudo vi/etc/hosts hosts 파일은 root로 수정해야한다 ! 그리고 아래와 같이 사용하는 API들을 넣어준..

[GCP] VM Instance 생성 및 고정 IP 할당

[GCP] VM Instance 생성 및 고정 IP 할당

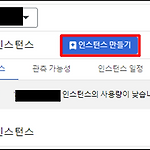

GCP에 VM Instance를 생성하는 법은 간단한 클릭 몇 번만으로 할 수 있다. 먼저 GCP에 로그인 한 후,[Compute Engine] → [VM 인스턴스] → [인스턴스 만들기] 를 클릭한다. 1. 머신 구성그리고 서버 용도에 맞는 머신의 스펙을 설정한다.나는 데이터를 daily로 ETL하기 위한 Airflow가 운영될 환경이라서 다음과 같은 스펙을 선택했다.리전 별, 머신 시리즈별로 CPU의 최대 코어수가 정해져있다.([IAM 및 관리자]→ [할당량 및 시스템 한도]로 가면 확인이 가능하다.)증액 요청을 하면 되긴 하는데 시간이 오래 걸릴 것 같아서 우선 해보고 나중에 부족하면 늘리기로 하였다. 그리고 부팅 디스크는 100GB로 늘려주었다.default가 10G였던 것 같은데 이게 나중에 ..

GCP Repositories를 사용해서 Airflow DAG 반영하기

GCP Repositories를 사용해서 Airflow DAG 반영하기

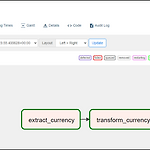

GCP에서 스케줄 작업을 할 때 가장 많이 사용하는 방법이VM Instance에 Airflow를 설치해서 사용하는 방법이다. 소스의 편한 형상관리와 Airflow DAG 코드를 쉽게 반영하기 위해서 GCP의 Repositories를 사용한다. 그래서 이번에는 GCP의 Repositories를 사용해서 DAG 코드를 Airflow 서버에 반영하는 방법에 대해서 간단하게 설명하려고 한다. 여기서 구성할 DAG는 Open API인 환율 구하는 API를 사용해서 전처리하여 daily로 해당일의 환율을 빅쿼리에 적재하려고 한다.더보기[DAG 코드는 다음과 같이 작성한 상태]환율 API 호출(extract) → 판다스를 통한 전처리(transform) → 빅쿼리 적재(load) 환율 APIAPI 호출을 위한 인증..